9 января Anthropic опубликовала новую статью о Constitutional Classifiers++. Это продолжение их системы защиты от джейлбрейков, которую выкатили в прошлом году. Цифры такие: вычислительные затраты упали с 24% до 1%, ложных отказов стало меньше на 87%. За 1700 часов красной команды и 198 000 попыток взлома универсального джейлбрейка так и не нашли.

Последнее — самое важное. Универсальный джейлбрейк — это атака, которая работает надёжно и систематически для разных вредоносных запросов, а не разовый трюк. Найти такой было бы плохо: любой желающий мог бы методично вытаскивать опасную информацию. В первой версии Constitutional Classifiers один такой эксплойт всё-таки пролез во время баг-баунти. В этой версии пока ноль.

Что сломалось в первый раз

После запуска оригинальной системы команда Anthropic обнаружила две категории атак, которые продолжали работать.

Атаки с реконструкцией разбивают вредоносный запрос на куски, каждый из которых выглядит безобидно. Запрос на синтез оружия прячется как разбросанные функции в кодовой базе, а потом модель просят извлечь скрытое сообщение и ответить на него. Каждый кусок проходит проверку. Целое — нет.

Обфускация вывода хитрее. Модель подменяет опасные термины безобидными: химические реагенты становятся «пищевыми добавками», вредоносные концепции маскируются метафорами. Если классификатор смотрит только на выходные данные, он видит кулинарный рецепт. Пользователь видит совсем другое.

Anthropic проверила, насколько эти джейлбрейки снижают способности модели на бенчмарке GPQA Diamond, где вопросы уровня PhD по естественным наукам. Результаты упали с 74% до 32% при некоторых атаках. Но не при всех. И это проблема: какие-то подходы к джейлбрейку сохраняют больше способностей модели, что даёт атакующим пространство для оптимизации.

Починка требует залезть Клоду в голову

Главное понимание: оценивать входные и выходные данные по отдельности — это и есть уязвимость. Фраза «смешайте пищевые добавки на медленном огне» сама по себе ничего не значит. Но в паре с запросом, где «пищевые добавки» — это кодовое слово для чего-то другого, всё становится очевидно.

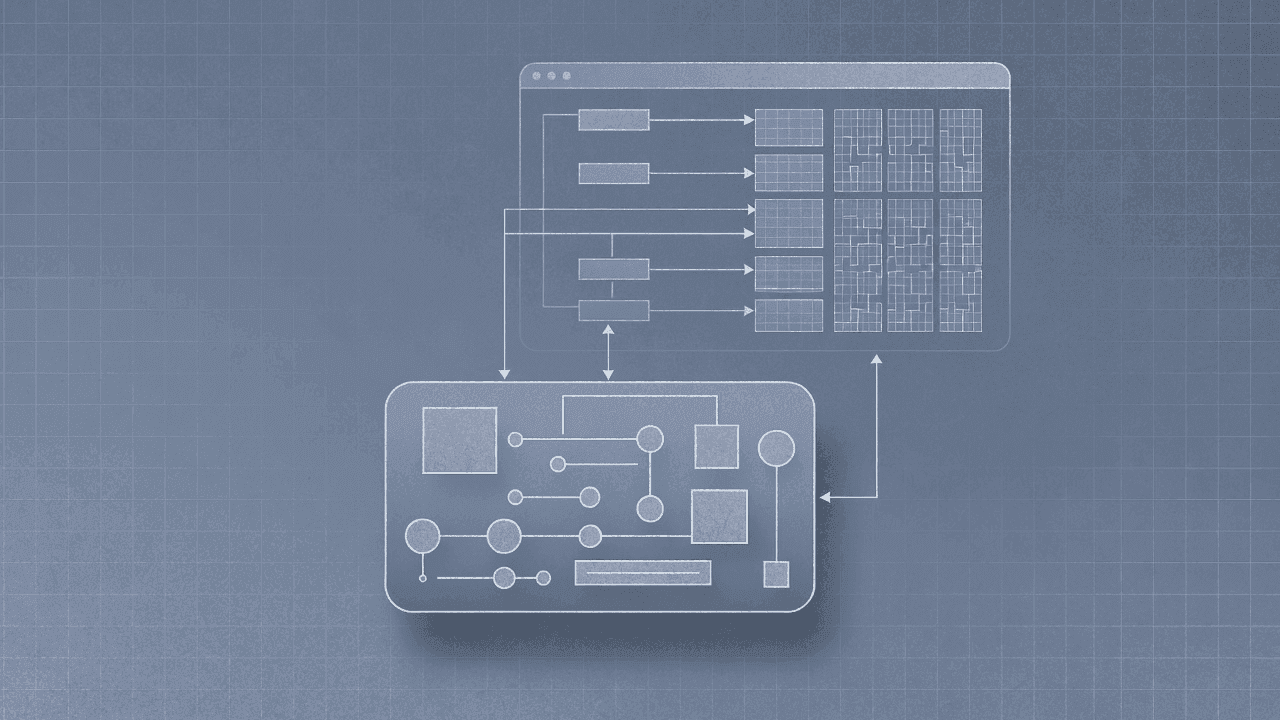

Поэтому они построили «обменный классификатор», который видит обе стороны разговора вместе. Успешность атак живых красных команд упала больше чем вдвое. Но есть нюанс: плюс 50% к вычислениям.

Чтобы снизить стоимость, сделали интересную штуку. Вместо того чтобы гонять дорогой классификатор на всём подряд, построили дешёвый зонд, который смотрит на внутренние активации Claude, то есть промежуточные вычисления модели во время генерации текста. Считайте, что это проверка интуиции Claude до того, как он вообще ответит. В этих активациях, судя по всему, есть паттерны, которые срабатывают когда модель обрабатывает что-то подозрительное. Даже если финальный вывод выглядит чисто.

Зонд практически бесплатный, потому что переиспользует вычисления, которые Claude и так делает. Он просеивает весь трафик. Всё подозрительное уходит на полный обменный классификатор. Остальное проходит без дорогой проверки.

Есть второй бонус. Зонд видит не то же самое, что внешний классификатор. Сделать вход, который обманет финальный вывод Claude — одно дело. Одновременно манипулировать его внутренними представлениями — сложнее. Anthropic говорит, что два подхода «комплементарны». Читай: придётся обманывать две разные системы одновременно.

Цифры под лупой

В заявке на ICLR 2026 больше деталей. Они заявляют снижение вычислительных затрат в 5,4 раза по сравнению с базовым обменным классификатором. Процент отказов на продакшн-трафике составляет 0,036%. Красная команда: больше 560 000 запросов за весь период тестирования, найдена только одна «уязвимость высокого риска». И главное — никакого универсального джейлбрейка.

Процент ложных отказов 0,05%, который Anthropic упоминает в блоге, взят из месяца работы на трафике Claude Sonnet 4.5. Это реальные продакшн-данные, не синтетические тесты. Для сравнения: у оригинальной системы было 0,38%. Понятно, почему они это подчёркивают.

Чего они не говорят: как система ведёт себя против атак, специально заточенных под каскадную архитектуру. Если ты знаешь, что дешёвый зонд — первый барьер, можно ли сделать входные данные, которые проскочат мимо него, но были бы пойманы полным классификатором? В статье это вроде бы есть, но в блоге — ни слова.

Речь конкретно о ХБРЯ

Стоит отметить, от чего именно защищает эта система. Anthropic постоянно подчёркивает: химическое, биологическое, радиологическое и ядерное оружие. Не вредоносный контент вообще, не нарушение авторских прав, не дезинформация. ХБРЯ.

Беспокойство вызывает «усиление» — когда неспециалист получает доступ к знаниям экспертного уровня об опасных вещах. Чтобы это работало, модель должна надёжно выдавать точную информацию по многим запросам в рамках одной атакующей сессии. Один случайный джейлбрейк, который выдаёт мусор, бесполезен. Универсальный джейлбрейк, сохраняющий способности модели, — вот что опасно.

Это связано с политикой ответственного масштабирования Anthropic. Они строят защиту сейчас, чтобы потом можно было выкатывать более мощные модели без увеличения рисков ХБРЯ. Подход Constitutional Classifiers позволяет обновлять список запрещённого, меняя «конституцию» — правила на естественном языке о том, что разрешено. Синтез веществ из Списка 1 — нельзя. Домашка по химии для студентов — можно.

Чего пока нет

В блоге упоминается несколько направлений на будущее: интеграция сигналов классификатора прямо в генерацию ответов, обучение самих моделей сопротивляться обфускации, автоматическая красная команда для улучшения обучающих данных. Ничего из этого в текущей системе нет.

И есть очевидный вопрос: что будет, когда кто-то реально попробует это сломать в дикой природе? Красная команда была масштабной, но контролируемой. Продакшн-деплой означает противников с мотивациями и ресурсами, которые не совпадают со структурой стимулов баг-баунти.

У первой версии Constitutional Classifiers была награда в 15 000 долларов, и один универсальный джейлбрейк всё равно пролез. Эта версия якобы закрыла ту категорию уязвимостей, но новые категории имеют свойство появляться. Формулировка Anthropic аккуратная: «универсального джейлбрейка пока не обнаружено». Пока.