В понедельник Artificial Analysis выкатил версию 4.0 своего Intelligence Index. Результаты отрезвляющие. Модели, которые раньше набирали под 70 баллов, теперь еле дотягивают до 50. GPT-5.2 от OpenAI с расширенным режимом рассуждений занял первое место с 50 баллами. Anthropic Claude Opus 4.5 отстаёт на один балл, Google Gemini 3 Pro — на два.

Разрыв между тройкой лидеров: два балла. Вот такой у нас фронтир в начале 2026-го.

Проблема насыщения

Пересмотр методологии решает проблему, о которой в индустрии тихо говорили несколько месяцев: традиционные бенчмарки перестали работать. Когда все крупные модели выбивают больше 90% на MMLU-Pro, какой в этом смысл? Различить системы невозможно, а компании, выбирающие модель для продакшена, гадают на кофейной гуще.

Artificial Analysis убрал три базовых теста: MMLU-Pro, AIME 2025 и LiveCodeBench. Те самые, которые ИИ-компании годами цитировали в пресс-релизах. Вместо них появились тесты, измеряющие способность моделей делать реальную работу.

Перекалибровка сделана намеренно. Снижение максимальных баллов с 73 до 50 освобождает место для будущего роста. Заполнится ли это место, посмотрим.

Что теперь тестируют

Новый индекс равномерно распределяет вес между четырьмя категориями: агенты, код, научные рассуждения и общие знания. Каждая даёт 25% итогового балла. Интересное скрывается в деталях.

GDPval-AA проверяет модели на экономически значимых задачах из 44 профессий и 9 отраслей. Модели получают доступ к командной строке и браузеру через агентскую оболочку Stirrup, после чего создают готовые продукты: документы, презентации, таблицы, диаграммы. То, за что людям платят деньги. GPT-5.2 лидирует с ELO 1442, версия Claude Opus 4.5 без режима рассуждений набрала 1403.

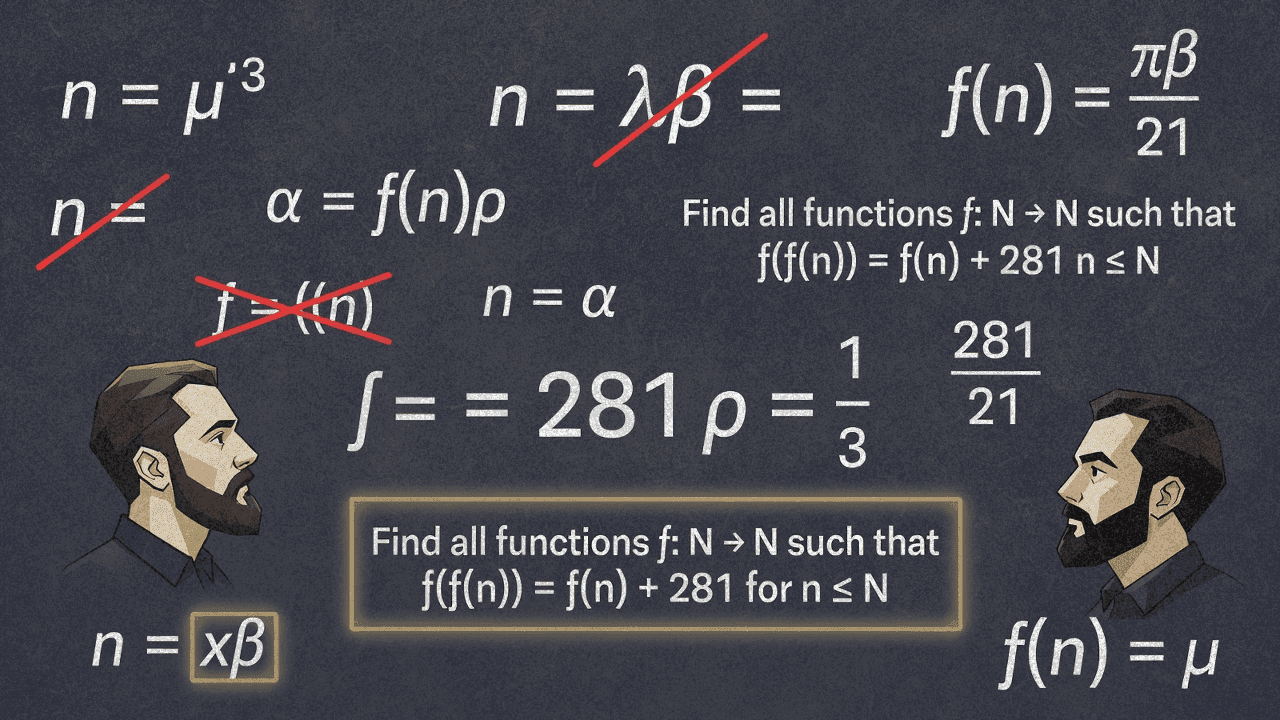

А вот CritPt — это уже серьёзно. Больше 50 физиков из более чем 30 институтов составили 71 задачу исследовательского уровня: физика конденсированного состояния, астрофизика, физика высоких энергий и ещё куча областей, для объяснения которых нужна учёная степень. Это не задачки из учебника. Это разминочные упражнения, которые научрук мог бы дать аспиранту-первогодке.

Лучший результат? GPT-5.2 с точностью 11,5%. Фронтир ИИ-рассуждений упирается в стену, когда его просят заняться настоящей физикой.

Компромисс с галлюцинациями

AA-Omniscience измеряет фактическую точность на 6000 вопросов и при этом явно штрафует за галлюцинации. Результаты вскрывают неприятную закономерность.

Модели Google Gemini лидируют по сырой точности (54% и 51% соответственно), но и галлюцинируют на уровне 88% и 85%. Когда они чего-то не знают, то в подавляющем большинстве случаев выдумывают ответ, а не признают незнание.

У моделей Anthropic Claude обратная картина. Точность ниже, зато Claude 4.5 Haiku показал самый низкий уровень галлюцинаций среди всех моделей: всего 26%. Claude 4.5 Sonnet и Claude Opus 4.5 набрали по 48%. GPT-5.2 где-то посередине: 51% точности и второй по качеству показатель галлюцинаций.

Индекс Omniscience штрафует за неправильные ответы так же сильно, как поощряет за правильные. Ноль баллов означает, что модель отвечает правильно и неправильно с одинаковой частотой. Только четыре модели набрали положительный балл. Большинство флагманских систем буквально чаще уверенно врут, чем дают правильный ответ.

Тем, кто внедряет такое в регулируемых отраслях, придётся как-то объяснять эти цифры комплаенсу.

Вопрос стоимости

Прогон полного набора тестов Intelligence Index 4.0 на GPT-5.2 обходится примерно в $2930, из которых $2361 уходит на режим рассуждений. Gemini 3 Pro Preview? Меньше $1000. Claude 4.5 Sonnet? Тоже меньше $1000.

Самая способная модель оказывается и самой дорогой в эксплуатации, причём втрое. Стоит ли эта наценка преимущества в два балла по бенчмарку (особенно учитывая, что вся тройка лидеров укладывается в погрешность измерения), каждая компания решает сама.

Чего этот индекс не показывает

Intelligence Index работает только с текстом и только на английском. Artificial Analysis тестирует изображения, речь и мультиязычность отдельно. Если ваш сценарий затрагивает что-то из этого, цифры показывают лишь часть картины.

И ещё: бенчмарк GDPval использует Gemini 3 Pro как модель-оценщик для попарных сравнений. Вносит ли это систематическое смещение в пользу моделей, чьи ответы нравятся Gemini, вопрос открытый. Artificial Analysis замораживает ELO-рейтинги на момент оценки, чтобы предотвратить подгонку, но выбор оценщика стоит держать в уме.

У бенчмарка CritPt тоже есть интересная оговорка: при составлении датасета задачи отбирались состязательно на основе тестов с GPT-4o, Gemini 1.5 Pro, Claude 3.5 Sonnet и несколькими вариантами o1. Авторы прямо не рекомендуют сравнивать результаты с моделями, не участвовавшими в отборе, поскольку датасет может быть смещён против них.

Что имеем в итоге

Тройная ничья на вершине подтверждает то, о чём многие догадывались: ни одна компания не вырвалась вперёд по общему интеллекту. OpenAI, Anthropic и Google идут практически вровень, меняясь местами в зависимости от конкретной способности.

Сам пересмотр бенчмарка, вероятно, важнее текущих рейтингов. Измеряя то, что модели реально могут произвести, а не какую тривию способны вспомнить, Intelligence Index 4.0 смещает разговор в сторону практической пользы. Это полезно.

Но главная история здесь — результаты CritPt. Флагманские ИИ-системы научились очень хорошо находить паттерны в гигантских обучающих корпусах. Они не научились строгому, творческому рассуждению, которого требует настоящая научная работа. 11,5% точности на вводных задачах по физике — это не тот разрыв, который закроется простым масштабированием.

Бенчмарки снова могут расти. Смогут ли модели расти вместе с ними — вопрос для 2026-го.