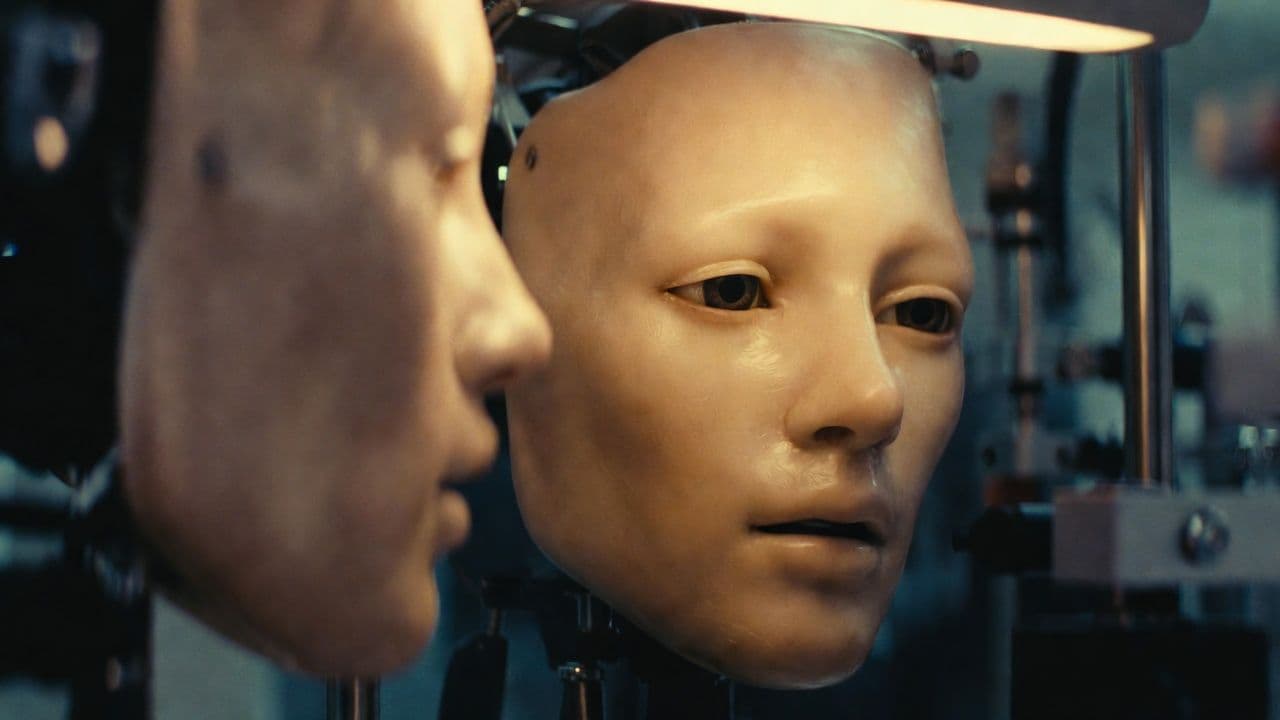

Исследователи из Columbia Engineering создали робота, который синхронизирует губы с речью и пением без явного программирования движений рта. Робот по имени Emo сначала практиковался, генерируя случайные выражения лица перед зеркалом, а потом часами смотрел видео с говорящими людьми на YouTube. Работа опубликована в Science Robotics 14 января 2026 года.

Проблема, о которой не принято говорить

Пока Boston Dynamics, Tesla и Figure AI вливают миллиарды в то, чтобы роботы ходили и хватали предметы, лица большинства гуманоидов застряли где-то между манекеном из универмага и куклой из фильма ужасов. И это важнее, чем кажется индустрии.

Почти половина нашего внимания во время разговора уходит на наблюдение за губами собеседника. Мы невероятно чувствительны к рассогласованию между тем, что слышим и видим. Даже небольшие ошибки запускают тот самый эффект зловещей долины: вязкий дискомфорт, когда что-то выглядит почти по-человечески, но не совсем. Японский робототехник Масахиро Мори описал этот феномен ещё в 1970 году. Прошло полвека, а проблема так и не решена.

Команда из Columbia Engineering под руководством Хода Липсона и аспиранта Юхана Ху пошла другим путём. Вместо того чтобы вручную прописывать правила движения рта для каждого звука, они позволили роботу разобраться самому через наблюдение.

Как Emo учился сам

Обучение шло в два этапа. Сначала исследователи посадили Emo перед зеркалом и заставили генерировать тысячи случайных выражений лица, наблюдая за собой. Постепенно робот выстроил то, что команда называет моделью «от зрения к действию»: понял, какие активации моторов дают какой внешний вид.

Потом начался запой на YouTube. Emo смотрел часы видео с говорящими и поющими людьми на разных языках. ИИ научился сопоставлять звуковые волны с формами рта, минуя язык как таковой. Никакого перевода. Система анализировала сырую связь между звуками и положением губ.

Само железо серьёзно доработали по сравнению с предыдущей платформой лаборатории, Eva, у которой было всего 10 актуаторов. В Emo упаковали 26 моторов под гибкую силиконовую кожу, управляемых магнитами прямого крепления, деформирующими поверхность. В каждый зрачок встроены камеры высокого разрешения для восприятия в реальном времени.

Что робот умеет на практике

Робот продемонстрировал синхронизацию губ на нескольких языках, включая французский, арабский и китайский, хотя ни один из них специально не тренировали. Он даже исполнил трек с ИИ-сгенерированного альбома «hello world_», справившись со сменой ритма и растянутыми гласными, которые делают пение особенно сложным.

Но исследователи честно говорят об ограничениях. Твёрдые согласные вроде «Б» остаются проблемными, как и звуки с вытянутыми губами типа «У». Движение губ далеко от идеала. Связано ли это с ограничениями железа или пробелами в обучающих данных, из опубликованного не вполне ясно.

Научная статья показывает, что метод превосходит пять существующих подходов по точности соответствия движений рта робота эталонным видео. Тесты на 11 неанглийских языках с разными фонетическими структурами показали, что система обобщает без специфической языковой подготовки. Цифры впечатляют, но к сравнениям бенчмарков в статьях по робототехнике стоит относиться со здоровым скепсисом: условия тестов сильно разнятся.

Недостающее звено?

Липсон называет мимику «недостающим звеном» робототехники. Он утверждает, что одержимость отрасли локомоцией и манипуляцией оставила целый канал коммуникации неосвоенным. В этом что-то есть. Нынешние усилия по созданию гуманоидов от Tesla, Boston Dynamics и других сосредоточены почти исключительно на ногах и руках. Лица остаются на втором плане, если о них вообще думают.

Видение, которое продаёт команда: совместите эту адаптивную синхронизацию губ с большими языковыми моделями типа ChatGPT или Gemini, и получите роботов, способных на настоящую эмоциональную связь. Как выразился Ху, чем длиннее контекстное окно разговора, тем более контекстно-зависимой становится мимика.

Это спекуляции, конечно. Но базовое техническое достижение реально. Робот, который учится координировать лицо с речью через наблюдение, а не программирование, представляет сдвиг в подходе. Это может иметь значение, когда гуманоиды придут в уход за пожилыми, образование и другие сферы, где человеческий контакт не опционален.

Исследователи признают очевидные опасения. Создание машин, способных эмоционально вовлекать людей, поднимает вопросы, на которые у них нет ответов. Позиция Липсона: осторожный оптимизм. Двигаться медленно, быть аккуратными, извлекать пользу, минимизируя риски. Проявит ли индустрия такую сдержанность на практике? Отдельный вопрос.

Финансирование поступило от NSF AI Institute for Dynamical Systems и от Amazon в виде гранта ИИ-институту Колумбии. Данные исследования доступны на Dryad.